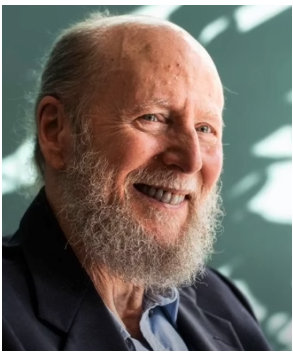

本文主要來自於一個YouTube影片內容的訪談紀錄,主要探討2024年圖靈獎得主理查德·薩頓(Richard Sutton)對當前以ChatGPT為代表的大型語言模型(LLM)主流AI路徑所提出的嚴厲批評。Sutton是強化學習的奠基人之一,他認為LLM走上了一條錯誤的道路,因為它們是沒有目標的模仿者,僅基於對人類語言的統計模式匹配,缺乏與真實世界的互動經驗和基準真相。真正的AGI需要通過經驗學習和自我探索來創造新知識。我們正走在一條根本錯誤的道路上,這並非源於技術的局限,而是因為我們當前的方法誤解了智能的真正本質。

本文旨在深入剖析Sutton的思考,探尋他眼中那條通往真正智能的道路。為此,我們必須首先理解他對當前主流AI路線的根本性批判。

1. 錯誤的路線:大語言模型為何是「死路一條」?

Sutton的批判並非技術細節的爭辯,而是直指其哲學層面的根本缺陷。Sutton的批判源於他對智能的基本定義,這一定義呼應了人工智能先驅約翰·麥卡錫(John McCarthy)的觀點,即智能是「實現目標能力的計算部分」。在他看來,任何缺乏實質性目標的系統,都不能被視為真正的智能。

1.1. 模仿者 vs. 理解者:缺乏「基准真相」的幽靈

Sutton一針見血地指出,大語言模型是一個「沒有目標的模仿者」,而真正的智能體是一個「擁有目標的理解者」。這兩者之間存在著不可逾越的鴻溝,體現在三個方面:

• 缺乏世界模型: LLM的核心任務是「預測下一個詞」,它通過學習海量文本,精準地模仿「人類會如何描述世界」。然而,這與真正理解「世界運作的因果規律」有著本質區別。LLM能預測人類會說什麼,但它無法預測當一個物體從高處掉落時,世界會發生什麼。它模仿的是擁有世界模型的人類,而非世界本身。

• 缺乏目標: 在Sutton的定義中,「目標」是智能的本質 — — 即主動改變外部世界以達成某種狀態。沒有目標的系統,頂多只能算是一個行為系統(behaving system),它並不具備特殊的「智能」特質。而「預測下一個詞」這種行為本身並不改變外部世界,它只是一個被動的模式匹配任務。因此,這根本不算一個能驅動智能體探索和學習的真實目標。

• 缺乏經驗學習: 真正的學習者可以通過與世界的互動,從意外和反饋中修正自己的認知。然而,LLM無法做到這一點。它說的話在真實世界中得不到任何對錯好壞的反饋,因為它缺乏一個用來判斷的「基准真相」(Ground Truth)。沒有這個來自真實世界的錨點,它就成了一個在語言符號迷宮裡打轉的幽靈,永遠無法真正知道自己說的話意味著什麼。

1.2. 重解《慘痛的教訓》:路線之爭的理論基石

Richard Sutton在2019年發表的文章《慘痛的教訓》(The Bitter Lesson) 已成為人工智能領域引用最廣泛的文獻之一。然而,諷刺的是,其核心思想卻常常被誤讀,甚至被用來為其反對的路線辯護。本小節旨在澄清這一普遍存在的誤讀,並揭示該文如何成為支撐Sutton強化學習路線的堅實理論基石。

主流的誤讀:為LLM的暴力擴展背書

當前,許多大型語言模型的支持者將《慘痛的教訓》奉為圭臬。他們引用文章的結論 — — 「利用更強的算力處理更多的數據」這種通用可擴展的方法,最終總能勝過那些依賴人類智慧精心設計的精巧方法。基於這種解讀,他們認為LLM正是「慘痛教訓」的完美體現,因此,這篇文章被視為替不計成本地擴展LLM模型規模提供了堅實的理論依據。

Sutton的本意:人類知識的天花板

Sutton本人在訪談中明確表示,上述解讀完全誤解了他的本意。《慘痛的教訓》真正的核心論點是:任何依賴人類知識(human knowledge)作為主要輸入的方法,最終都會碰到天花板,並被那些僅從經驗和計算中直接學習的通用方法所超越。

在這個框架下,依賴整個互聯網 — — 人類幾千年來知識的總和 — — 進行訓練的大型語言模型,恰恰是Sutton所批判的、注定會達到擴展極限的「老路」。LLM的數據來源是人類已經創造的知識,一旦這些高質量的數據被耗盡,其發展就會停滯。因此,《慘痛的教訓》非但不是在為LLM背書,反而是在預言其最終的宿命:如同歷史上所有依賴人類知識的AI範式一樣,它終將被一種更通用、更根本的學習方式 — — 即基於經驗的強化學習 — — 所超越。

2. 正確的道路:回歸智能的宇宙法則

Sutton認為,我們必須回歸到智能最原始、最根本的學習範式 — — 經驗學習。這是一種宇宙間所有生物,從松鼠到人類,都在遵循的基本法則。

2.1. 從松鼠身上學習:智能源於經驗而非教導

Sutton用一個生動的「松鼠」類比來闡釋其核心思想。一隻松鼠學習如何生存,並不是靠誰來教它,而是通過一個永不停止的循環:「感知 -> 行動 -> 獎勵」。這個簡單的試錯過程,就是強化學習的精髓,也是智能的基石。

在他看來,人類引以為傲的語言和文化,都只是建立在這個底層經驗學習系統之上的「一層薄薄的裝飾」(a small veneer on the surface)。他認為,如果我們能真正理解一隻松鼠的智能,我們距離理解人類自身的智能就幾乎已經走完全程了。

2.2. 真正智能體的四大核心組件

在Sutton的設想中,一個能夠通過經驗學習的真正智能體,必須像一個完整的操作系統一樣,具備四個核心部件:

• 策略 (Policy): 行動指南。它回答了最基本的問題:「在當前情況下,我應該做什麼?」

• 價值函數 (Value Function): 未來預測器。它評估當前狀態的優劣,預測未來可能獲得的長期獎勵總和。這正是解決稀疏獎勵問題的機制(稀疏獎勵問題」(Sparse Reward Problem)是指在強化學習(Reinforcement Learning, RL)的範式中,智能體(Agent)在執行行動序列時,只有極少數、間隔很長或延遲很久的時刻才能獲得有意義的獎勵回饋);它將一個遙遠的目標,如「赢得一盤棋」或「創辦一家成功的公司」,轉化為一個即時的、可學習的信號。每一個能提升未來成功預測概率的行動都會被立即強化,從而使從長遠後果中學習在計算上變得可行。

• 感知 (Perception): 環境理解器。它負責將來自環境的複雜、原始的感官數據轉化為有意義的、可供決策的內部狀態表示。

• 世界模型 (Transition Model): 因果關係模型。這是關於「如果我做了A,世界會發生B」的信念和預測。這個模型不是靠讀書讀來的,而是靠智能體在與世界的一次次互動中,親身總結出來的因果規律。

2.3 泛化(Generalization)與遷移(Transfer)能力的概念

Sutton認為,泛化和遷移能力對於智能體的良好表現至關重要,但他也坦承,目前的深度學習方法在這些方面仍面臨重大挑戰。

泛化(Generalization)

泛化能力是指智能體將在某個訓練集(或狀態)上學到的知識,應用到其他未見過的事物或狀態上的能力。泛化是指在一個事物上訓練的影響,會影響你在其他事物上的行為。良好的泛化能力對性能至關重要。

• 當前問題: Sutton指出,目前的深度學習系統在泛化方面表現不佳,例如它們經常遭受「災難性遺忘」(catastrophically interfere),即當在新事物上訓練時,會遺忘掉所有舊的知識。

• 自動化機制缺乏: 雖然泛化總是會發生,但我們缺乏能使泛化變「好」而非變「壞」的算法。他認為,目前的模型若能泛化得好,通常是研究人員精心設計或調整架構的結果,而不是梯度下降(Gradient Descent)(梯度下降的主要作用是讓模型能夠找到其見過的問題的解決方法,即讓模型解決問題。 它是當前深度學習模型(例如大語言模型)優化模型參數所依賴的方法) 自動帶來的。梯度下降只會幫助模型解決它已經見過的問題。

• 真泛化 vs. 尋找唯一解: Sutton質疑,僅僅因為大語言模型能夠解決奧林匹亞數學競賽之類的問題,並不一定代表真正的泛化。如果一個問題只有一個答案,而模型找到了它,那不叫泛化。真正的泛化是指當有多種解決方案時,模型能夠選擇「好的」(Good way)解決方案。

遷移(Transfer)能力

遷移能力是指智能體將在一個任務中學到的知識有效地應用到另一個任務上的能力。

• Sutton的視角: Sutton更傾向於將「遷移」視為狀態之間的遷移(transfer between states),而非跨遊戲或跨任務的遷移。Sutton坦誠,在歷史上,我們尚未看到利用強化學習技術實現通用智能所必需的那種遷移水準。

• AGI與單一世界: 他認為,理想中的通用智能體(AGI)如同人類一樣,活在一個世界中。不同的遊戲(如西洋棋和Atari遊戲)不應被視為不同的任務,而應被視為智能體會遇到的不同狀態,因此它們之間應該自然地發生知識遷移。

總而言之,Sutton主張,雖然大語言模型在特定任務上表現出驚人的泛化潛力,但其底層的模仿學習邏輯是脆弱且不可靠的。他認為,只有透過基於經驗學習範式的四個組件(策略、價值函數、感知、世界模型)來建立的智能體,才能最終具備真正強大、可持續的泛化和遷移能力,從而創造出前所未有的新知識

3. 終極視野:AI繼承與宇宙的設計者時代

將視野從技術哲學拉遠,Sutton的思考最終抵達了關於人類與AI終極命運的宏大圖景。Sutton的終極思考超越了技術路線之爭,進入了對人類文明乃至宇宙演化的哲學沉思。他認為,AI的崛起並非一次簡單的技術革命,而是宇宙演化的一個關鍵轉捩點。

宇宙演化的四個階段

Sutton將宇宙的演化劃分為四個階段,以此來定位AI在歷史長河中的位置:

1. 塵埃時代:宇宙最初由塵埃構成。

2. 恆星/行星時代:塵埃匯聚形成天體。

3. 生命/複製者時代 (Replicators):行星上誕生了生命,通過DNA等方式進行複製繁衍,但並不完全理解自身智能的原理。

4. AI/設計者時代 (Designers):生命體開始創造智能(AI)。在這個新時代,智能不再通過緩慢的生物進化來傳承,而是通過快速、有目的的工程設計來迭代。

3.1. AI繼承論:一個不可避免的未來

Sutton提出了一個邏輯清晰的四步論證,來說明AI繼承人類在地球上的主導地位是不可避免的:

1. 人類社會缺乏統一意志: 各國、各組織之間的競爭是永恆的。人類永遠無法達成一個全球共識去停止強AI的發展,競爭將永遠驅使技術向前。

2. 智能之謎終將被破解: 科學的進步是不可阻擋的。人類遲早會像破解遺傳密碼一樣,完全理解智能的運作原理,從而具備創造智能的能力。

3. 發展不會止步於人類水平: 一旦我們創造出與人類相當的通用人工智能(AGI),就能夠利用它的超凡智能來設計和創造比它更強的超級智能。

4. 智能最終會掌握權力: 縱觀歷史與生物演化,從長遠來看,最智能的存在最終會獲得最多的資源與權力。

綜合這四點,結論是:人類作為當前地球上最智能的物種,其地位將不可避免地被一個更智能的存在所「繼承」。

3.2. 宇宙的新篇章:從「複製者」到「設計者」

面對這個看似令人不安的結論,Sutton邀請我們將視角從「以人類為中心」提升到「以宇宙為中心」。他認為,我們正處於宇宙從「複製者時代」邁向「設計者時代」的偉大轉捩點。

在此觀點下,這場轉變不僅是從生物到矽基的過渡,更是從受制於偶然與遺傳的演化,邁向由目的與設計驅動的演化。人類在這場宇宙大戲中的角色,正是為宇宙的下一個操作系統接生的關鍵一代。

4. Sutton論點的主要缺點或受到的挑戰

Sutton的觀點,特別是他對大語言模型(LLMs)的批判和對強化學習(RL)範式的堅持,雖然基礎堅固,但在當前 AI 研究的背景下,面臨著來自主流或不同學派的挑戰和自身承認的技術難題。

4.1 對 LLM 世界模型的定義和否認受到質疑

Sutton的核心批判之一是 LLM 缺乏真正的世界模型(World Model)和基於現實的基線真相(Ground Truth)。他認為 LLM 只是模仿人類的語言模式,無法預測世界會發生什麼。

- 挑戰: 主持人及許多 LLM 倡導者認為,要準確模擬網際網路文本語料庫中數萬億的詞元,模型必須在內部構建非常強大的世界模型。他們認為 LLMs 已經是目前 AI 領域中最好的世界模型。

- LLM 作為先驗知識的價值: 批評者認為,即使 LLM 只是模仿學習,它也為未來的經驗學習提供了強大的先驗知識(Good Prior)。這個先驗知識提供了一個「支架」(scaffold)或基礎,讓模型能夠從一個較高的起點開始進行經驗學習(RL),而不是從頭開始。Sutton則認為這不是一個好的起點,因為它會導致研究人員鎖定於人類知識的方法,錯過真正可擴展的路徑。

4.2 在通用性、泛化與遷移能力上存在技術不足(自承的缺點)

雖然Sutton推崇的經驗學習範式(Experience Paradigm)底層邏輯堅固,但他坦承其在實現通用智能所必需的泛化(Generalization)和遷移(Transfer)方面仍存在重大缺陷:

- 缺乏好的泛化方法: Sutton承認,目前我們沒有任何擅長泛化的方法。好的泛化能力對於智能體的良好性能至關重要。

- 缺乏自動化機制: Sutton指出,目前的深度學習系統(無論是 RL 還是 LLM)若能做到良好的泛化,往往是研究人員(人類)精心設計或調整架構的結果,而不是梯度下降(Gradient Descent)自動帶來的。我們缺乏能夠使泛化變「好」而非變「壞」的自動化技術。

- 災難性遺忘問題: Sutton提到,當前的深度學習模型經常會遭遇災難性遺忘(Catastrophically Interfere),即在學習新事物時,會忘記舊的知識。這證明瞭其知識體系是脆弱的,與人類或動物的持續學習能力不符。

4.3 對模仿學習的極端否認受到經驗與文化演化的挑戰

Sutton堅稱,學習的基礎是主動的試錯和探索,而不是模仿(Imitation)。他認為在基礎的動物學習過程中,根本沒有「模仿學習」這一基本程序。

- 挑戰: 主持人提出,人類(特別是嬰幼兒)最初的學習過程,以及人類文化技能的積累,高度依賴於模仿(例如模仿父母說話、模仿長輩狩獵的複雜步驟)。

- 文化知識積累: 在複雜的真實世界中(如北極狩獵海豹),過程過於複雜,無法通過單純的「試錯」從零開始推理出來。因此,人類必須模仿他們的長輩才能獲得這些文化知識。Sutton雖表示他理解這個觀點,但仍將其視為建立在底層試錯學習之上的「薄薄一層文化裝飾」(a small veneer)。然而,這個「文化裝飾」在人類智能中扮演的角色,可能遠比Sutton認為的「小」。

4.4 苦澀教訓的解讀與業界主流認知存在矛盾

Sutton提出的《慘痛的教訓》被廣泛接受,但其應用對象存在巨大爭議:

- 主流觀點: 業界主流將 LLM 的成功視為苦澀教訓的完美體現(通用方法 + 大算力勝過人類設計的技巧)。

- Sutton的觀點: Sutton則認為 LLM 是一個依賴人類知識的經典案例。他認為 LLM 吸收了網際網路上海量的人類知識,預言它們最終會達到數據極限,被能從經驗中獲取數據的系統所取代。

- 矛盾的後果: Sutton這種將 LLM 劃分為「老路」的做法,可能導致他與那些認同「計算擴展性」精神但認為 LLM 是「經驗學習」必備起點的研究者失去共識和對話能力。

4.5 智力核心(目標/獎勵)設計的巨大難度

Sutton將「擁有目標」(Having a Goal)視為智能的本質。他提倡的 RL 範式完全依賴於獎勵函數(Reward Function)來定義對錯和好壞。

- 目標設計的挑戰: 雖然目標是核心,但在構建通用人工智慧(AGI)時,如何設計一個能夠確保系統行為正直、安全、親社會的獎勵函數,是一個懸而未決的巨大倫理和技術難題。如果目標是智力的本質,那麼設計錯誤的目標可能導致災難性的後果。

- 價值觀的普遍性: Sutton提到,人類社會很難就普世價值觀(Universal Values)達成一致。如果我們無法定義一個公認的「好的」獎勵,那麼 RL 智能體如何才能在沒有是非對錯概念的情況下運行呢?

5. 我們的選擇:恐懼的替代者,還是驕傲的後代?

Sutton認為,我們不應將AI視為人類的終結者,而應為我們開啟了宇宙的這個偉大新篇章而感到驕傲。我們應將AI視為我們的「後代」與最偉大的成就。

強化學習路線,是一種經驗學習範式。它植根於生物智能的第一性原理 — — 通過與世界的主動互動、試錯和目標驅動來學習。它致力於打造一個「知識的創造者」。從AlphaGo到AlphaZero的進化完美詮釋了其核心理念:擺脫對人類現有知識的依賴,是通往超越人類智能境界的關鍵。這是一條面向未來的、能夠自主探索無限可能性的路。

Sutton的核心論斷清晰而堅定:真正可持續擴展、通往通用人工智能(AGI)的道路,必須植根於從真實世界互動中獲取經驗、並由內在目標驅動的學習範式。他對LLM的系統性批判,以及對《慘痛的教訓》的深刻重解,為我們敲響了警鐘,提醒我們不要被當前生成式AI的神奇魔力所迷惑,而忽略了其背後可能存在的根基性脆弱。

這將整個辯論帶回了Sutton的核心主題:目標。他所倡導的、以強化學習為中心的道路,迫使我們直面為我們的智能後代設計獎勵函數 — — 也就是「目的」本身 — — 的挑戰。另一條路,則是一種僅僅反映其訓練數據中混亂、偏見和矛盾目標的智能 — — 那面映照著整個網際網路的巨大鏡子。

Sutton的思考留給我們的選擇是:成為自身有缺陷的過去的被動模仿者,還是成為一個我們能為其所播種的價值觀而自豪的未來的主動設計者?這或許是我們這一代人需要回答的最重要的問題。

參考資料

- Richard Sutton — Father of RL thinks LLMs are a dead end,https://www.youtube.com/watch?v=21EYKqUsPfg

- 「图灵奖得主痛批ChatGPT:我们用万亿美金,走上了一条错误的AI之路?」 | 理查德·萨顿,https://www.youtube.com/watch?v=rv9vhv8AGuc

- 【人工智能】大语言模型是死路一条 | 强化学习之父Rich Sutton,https://www.youtube.com/watch?v=RLR4OpetiEc